Tomasz Parkoła

Director of Network Services Division at PCSS

Damian Niemir

Kierownik Działu Współpracy i Kontaktów z Otoczeniem w Poznańskim Centrum Superkomputerowo-Sieciowym (PCSS)

Damian Niemir

Kierownik Działu Współpracy i Kontaktów z Otoczeniem w Poznańskim Centrum Superkomputerowo-Sieciowym (PCSS)

Kierownik Działu Współpracy i Kontaktów z Otoczeniem w Poznańskim Centrum Superkomputerowo-Sieciowym (PCSS), absolwent Politechniki Poznańskiej. Twórca i współtwórca licznych projektów oraz inicjatyw popularyzujących naukę i nowe technologie. Zawodowo związany z obszarem komunikacji, organizacji wydarzeń oraz współpracy instytucjonalnej; organizator konferencji, spotkań i wystaw realizowanych dla PCSS oraz Konsorcjum PIONIER.

Zainteresowany projektowaniem graficznych interfejsów użytkownika, mediami elektronicznymi oraz sferą audiowizualną Internetu nowej generacji. Od początku swojej drogi zawodowej uważnie obserwuje rozwój Internetu i jego wpływ na przemiany cywilizacyjne, pozostając zarówno jego entuzjastą, jak i krytycznym obserwatorem — szczególnie w kontekście dynamicznego rozwoju sztucznej inteligencji i technologii kwantowych.

Informatyk i inżynier z wykształcenia, grafik i projektant gier z zamiłowania, muzyk z pasji. Gitarzysta i kompozytor od najmłodszych lat, łączy kompetencje techniczne z wrażliwością artystyczną. Pasjonat nowych mediów, poszukujący innowacyjnych form interakcji i immersji oraz twórca kreatywnych scenariuszy wykorzystania technologii w życiu codziennym.

Od kilkunastu lat aktywnie działa na rzecz integracji świata nauki i sztuki, konsekwentnie promując interdyscyplinarną współpracę artystów, informatyków i badaczy oraz tłumacząc złożone zagadnienia naukowe na język zrozumiały dla szerokiego grona odbiorców.

Damian Niemir

Kierownik Działu Współpracy i Kontaktów z Otoczeniem w Poznańskim Centrum Superkomputerowo-Sieciowym (PCSS)

Damian Niemir

Kierownik Działu Współpracy i Kontaktów z Otoczeniem w Poznańskim Centrum Superkomputerowo-Sieciowym (PCSS)

Kierownik Działu Współpracy i Kontaktów z Otoczeniem w Poznańskim Centrum Superkomputerowo-Sieciowym (PCSS), absolwent Politechniki Poznańskiej. Twórca i współtwórca licznych projektów oraz inicjatyw popularyzujących naukę i nowe technologie. Zawodowo związany z obszarem komunikacji, organizacji wydarzeń oraz współpracy instytucjonalnej; organizator konferencji, spotkań i wystaw realizowanych dla PCSS oraz Konsorcjum PIONIER.

Zainteresowany projektowaniem graficznych interfejsów użytkownika, mediami elektronicznymi oraz sferą audiowizualną Internetu nowej generacji. Od początku swojej drogi zawodowej uważnie obserwuje rozwój Internetu i jego wpływ na przemiany cywilizacyjne, pozostając zarówno jego entuzjastą, jak i krytycznym obserwatorem — szczególnie w kontekście dynamicznego rozwoju sztucznej inteligencji i technologii kwantowych.

Informatyk i inżynier z wykształcenia, grafik i projektant gier z zamiłowania, muzyk z pasji. Gitarzysta i kompozytor od najmłodszych lat, łączy kompetencje techniczne z wrażliwością artystyczną. Pasjonat nowych mediów, poszukujący innowacyjnych form interakcji i immersji oraz twórca kreatywnych scenariuszy wykorzystania technologii w życiu codziennym.

Od kilkunastu lat aktywnie działa na rzecz integracji świata nauki i sztuki, konsekwentnie promując interdyscyplinarną współpracę artystów, informatyków i badaczy oraz tłumacząc złożone zagadnienia naukowe na język zrozumiały dla szerokiego grona odbiorców.

Damian Niemir

Kierownik Działu Współpracy i Kontaktów z Otoczeniem w Poznańskim Centrum Superkomputerowo-Sieciowym (PCSS)

Damian Niemir

Kierownik Działu Współpracy i Kontaktów z Otoczeniem w Poznańskim Centrum Superkomputerowo-Sieciowym (PCSS)

Kierownik Działu Współpracy i Kontaktów z Otoczeniem w Poznańskim Centrum Superkomputerowo-Sieciowym (PCSS), absolwent Politechniki Poznańskiej. Twórca i współtwórca licznych projektów oraz inicjatyw popularyzujących naukę i nowe technologie. Zawodowo związany z obszarem komunikacji, organizacji wydarzeń oraz współpracy instytucjonalnej; organizator konferencji, spotkań i wystaw realizowanych dla PCSS oraz Konsorcjum PIONIER.

Zainteresowany projektowaniem graficznych interfejsów użytkownika, mediami elektronicznymi oraz sferą audiowizualną Internetu nowej generacji. Od początku swojej drogi zawodowej uważnie obserwuje rozwój Internetu i jego wpływ na przemiany cywilizacyjne, pozostając zarówno jego entuzjastą, jak i krytycznym obserwatorem — szczególnie w kontekście dynamicznego rozwoju sztucznej inteligencji i technologii kwantowych.

Informatyk i inżynier z wykształcenia, grafik i projektant gier z zamiłowania, muzyk z pasji. Gitarzysta i kompozytor od najmłodszych lat, łączy kompetencje techniczne z wrażliwością artystyczną. Pasjonat nowych mediów, poszukujący innowacyjnych form interakcji i immersji oraz twórca kreatywnych scenariuszy wykorzystania technologii w życiu codziennym.

Od kilkunastu lat aktywnie działa na rzecz integracji świata nauki i sztuki, konsekwentnie promując interdyscyplinarną współpracę artystów, informatyków i badaczy oraz tłumacząc złożone zagadnienia naukowe na język zrozumiały dla szerokiego grona odbiorców.

Tomasz Parkoła

Director of Network Services Division at PCSS

Damian Niemir

Kierownik Działu Współpracy i Kontaktów z Otoczeniem w Poznańskim Centrum Superkomputerowo-Sieciowym (PCSS)

Damian Niemir

Kierownik Działu Współpracy i Kontaktów z Otoczeniem w Poznańskim Centrum Superkomputerowo-Sieciowym (PCSS)

Kierownik Działu Współpracy i Kontaktów z Otoczeniem w Poznańskim Centrum Superkomputerowo-Sieciowym (PCSS), absolwent Politechniki Poznańskiej. Twórca i współtwórca licznych projektów oraz inicjatyw popularyzujących naukę i nowe technologie. Zawodowo związany z obszarem komunikacji, organizacji wydarzeń oraz współpracy instytucjonalnej; organizator konferencji, spotkań i wystaw realizowanych dla PCSS oraz Konsorcjum PIONIER.

Zainteresowany projektowaniem graficznych interfejsów użytkownika, mediami elektronicznymi oraz sferą audiowizualną Internetu nowej generacji. Od początku swojej drogi zawodowej uważnie obserwuje rozwój Internetu i jego wpływ na przemiany cywilizacyjne, pozostając zarówno jego entuzjastą, jak i krytycznym obserwatorem — szczególnie w kontekście dynamicznego rozwoju sztucznej inteligencji i technologii kwantowych.

Informatyk i inżynier z wykształcenia, grafik i projektant gier z zamiłowania, muzyk z pasji. Gitarzysta i kompozytor od najmłodszych lat, łączy kompetencje techniczne z wrażliwością artystyczną. Pasjonat nowych mediów, poszukujący innowacyjnych form interakcji i immersji oraz twórca kreatywnych scenariuszy wykorzystania technologii w życiu codziennym.

Od kilkunastu lat aktywnie działa na rzecz integracji świata nauki i sztuki, konsekwentnie promując interdyscyplinarną współpracę artystów, informatyków i badaczy oraz tłumacząc złożone zagadnienia naukowe na język zrozumiały dla szerokiego grona odbiorców.

Damian Niemir

Kierownik Działu Współpracy i Kontaktów z Otoczeniem w Poznańskim Centrum Superkomputerowo-Sieciowym (PCSS)

Damian Niemir

Kierownik Działu Współpracy i Kontaktów z Otoczeniem w Poznańskim Centrum Superkomputerowo-Sieciowym (PCSS)

Kierownik Działu Współpracy i Kontaktów z Otoczeniem w Poznańskim Centrum Superkomputerowo-Sieciowym (PCSS), absolwent Politechniki Poznańskiej. Twórca i współtwórca licznych projektów oraz inicjatyw popularyzujących naukę i nowe technologie. Zawodowo związany z obszarem komunikacji, organizacji wydarzeń oraz współpracy instytucjonalnej; organizator konferencji, spotkań i wystaw realizowanych dla PCSS oraz Konsorcjum PIONIER.

Zainteresowany projektowaniem graficznych interfejsów użytkownika, mediami elektronicznymi oraz sferą audiowizualną Internetu nowej generacji. Od początku swojej drogi zawodowej uważnie obserwuje rozwój Internetu i jego wpływ na przemiany cywilizacyjne, pozostając zarówno jego entuzjastą, jak i krytycznym obserwatorem — szczególnie w kontekście dynamicznego rozwoju sztucznej inteligencji i technologii kwantowych.

Informatyk i inżynier z wykształcenia, grafik i projektant gier z zamiłowania, muzyk z pasji. Gitarzysta i kompozytor od najmłodszych lat, łączy kompetencje techniczne z wrażliwością artystyczną. Pasjonat nowych mediów, poszukujący innowacyjnych form interakcji i immersji oraz twórca kreatywnych scenariuszy wykorzystania technologii w życiu codziennym.

Od kilkunastu lat aktywnie działa na rzecz integracji świata nauki i sztuki, konsekwentnie promując interdyscyplinarną współpracę artystów, informatyków i badaczy oraz tłumacząc złożone zagadnienia naukowe na język zrozumiały dla szerokiego grona odbiorców.

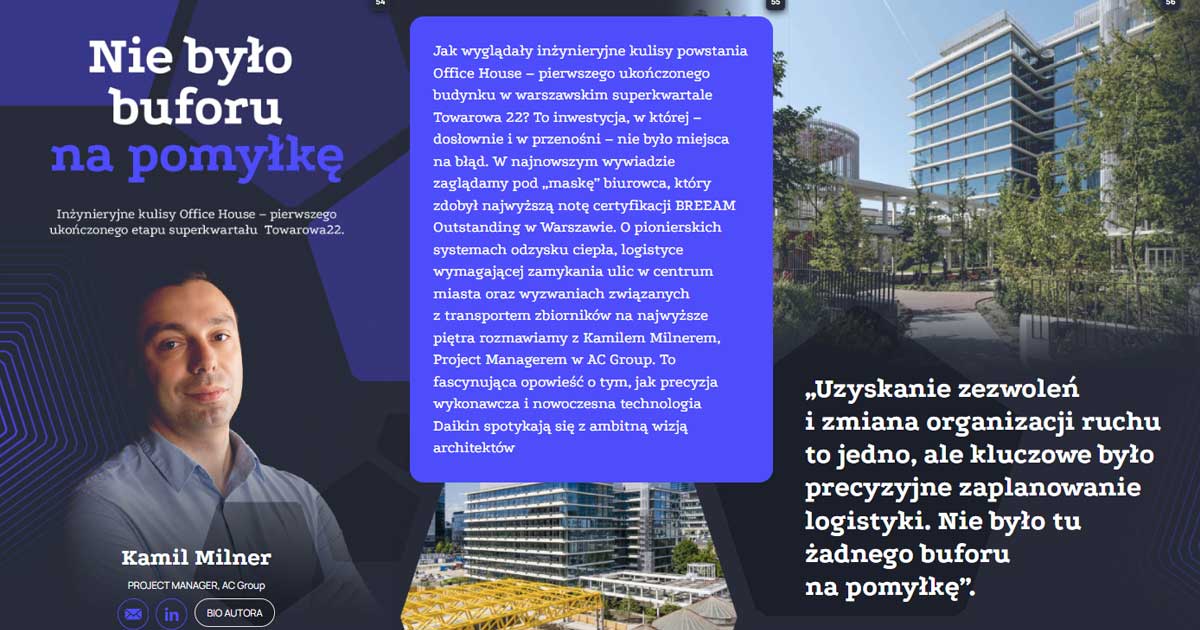

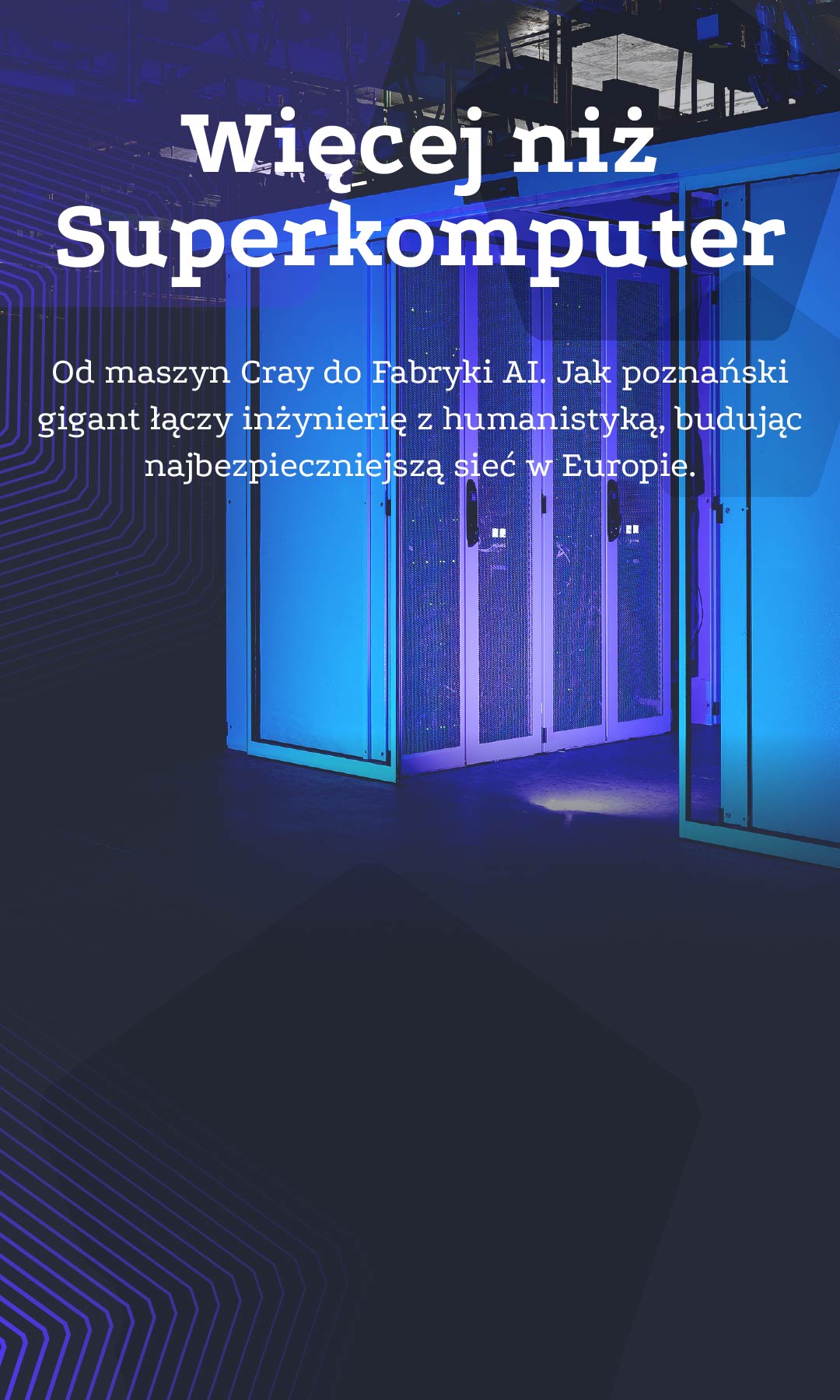

Gdy myślimy o centrum danych, przed oczami stają rzędy serwerów i chłodzenie – perspektywa techniczna. Jednak w świecie HPC i innowacji to już zdecydowanie za mało. Czy możliwym jest, aby jeden ośrodek łączył potrzeby bibliotekarza, rolnika, lekarza i inżyniera, tworząc dla każdego z nich przełomowe rozwiązania? Poznańskie Centrum Superkomputerowo-Sieciowe to dowód na to, że tak. To historia o tym, jak z niewielkiego zespołu narodził się gigant, który dziś jest operatorem jednej z najszybszych sieci naukowych świata (PIONIER) oraz właścicielem potężnego komputera kwantowego opartego na technologii pułapek jonowych. Już nie infrastruktura, a multidyscyplinarność i proaktywny gen B+R stanowią ich największą, niedocenianą wartość.

Gdy myślimy o centrum danych, przed oczami stają rzędy serwerów i chłodzenie – perspektywa techniczna. Jednak w świecie HPC i innowacji to już zdecydowanie za mało. Czy możliwym jest, aby jeden ośrodek łączył potrzeby bibliotekarza, rolnika, lekarza i inżyniera, tworząc dla każdego z nich przełomowe rozwiązania? Poznańskie Centrum Superkomputerowo-Sieciowe to dowód na to, że tak. To historia o tym, jak z niewielkiego zespołu narodził się gigant, który dziś jest operatorem jednej z najszybszych sieci naukowych świata (PIONIER) oraz właścicielem potężnego komputera kwantowego opartego na technologii pułapek jonowych. Już nie infrastruktura, a multidyscyplinarność i proaktywny gen B+R stanowią ich największą, niedocenianą wartość.

Gdy myślimy o centrum danych, przed oczami stają rzędy serwerów i chłodzenie – perspektywa techniczna. Jednak w świecie HPC i innowacji to już zdecydowanie za mało. Czy możliwym jest, aby jeden ośrodek łączył potrzeby bibliotekarza, rolnika, lekarza i inżyniera, tworząc dla każdego z nich przełomowe rozwiązania? Poznańskie Centrum Superkomputerowo-Sieciowe to dowód na to, że tak. To historia o tym, jak z niewielkiego zespołu narodził się gigant, który dziś jest operatorem jednej z najszybszych sieci naukowych świata (PIONIER) oraz właścicielem potężnego komputera kwantowego opartego na technologii pułapek jonowych. Już nie infrastruktura, a multidyscyplinarność i proaktywny gen B+R stanowią ich największą, niedocenianą wartość.

Gdy myślimy o centrum danych, przed oczami stają rzędy serwerów i chłodzenie – perspektywa techniczna. Jednak w świecie HPC i innowacji to już zdecydowanie za mało. Czy możliwym jest, aby jeden ośrodek łączył potrzeby bibliotekarza, rolnika, lekarza i inżyniera, tworząc dla każdego z nich przełomowe rozwiązania? Poznańskie Centrum Superkomputerowo-Sieciowe to dowód na to, że tak. To historia o tym, jak z niewielkiego zespołu narodził się gigant, który dziś jest operatorem jednej z najszybszych sieci naukowych świata (PIONIER) oraz właścicielem potężnego komputera kwantowego opartego na technologii pułapek jonowych. Już nie infrastruktura, a multidyscyplinarność i proaktywny gen B+R stanowią ich największą, niedocenianą wartość.

Gdy myślimy o centrum danych, przed oczami stają rzędy serwerów i chłodzenie – perspektywa techniczna. Jednak w świecie HPC i innowacji to już zdecydowanie za mało. Czy możliwym jest, aby jeden ośrodek łączył potrzeby bibliotekarza, rolnika, lekarza i inżyniera, tworząc dla każdego z nich przełomowe rozwiązania? Poznańskie Centrum Superkomputerowo-Sieciowe to dowód na to, że tak. To historia o tym, jak z niewielkiego zespołu narodził się gigant, który dziś jest operatorem jednej z najszybszych sieci naukowych świata (PIONIER) oraz właścicielem potężnego komputera kwantowego opartego na technologii pułapek jonowych. Już nie infrastruktura, a multidyscyplinarność i proaktywny gen B+R stanowią ich największą, niedocenianą wartość.

„Jeśli miałbym wskazać naszą największą wartość, to jest nią właśnie multidyscyplinarność. Zajmujemy się bardzo wieloma, często odległymi od siebie dziedzinami. To jest nasza unikalna cecha (w skali Europy, jak również świata). Pozwala to spojrzeć na realizowane działania z różnych perspektyw, wyzwalając tym samym kolejne innowacje.”

„Jeśli miałbym wskazać naszą największą wartość, to jest nią właśnie multidyscyplinarność. Zajmujemy się bardzo wieloma, często odległymi od siebie dziedzinami. To jest nasza unikalna cecha (w skali Europy, jak również świata). Pozwala to spojrzeć na realizowane działania z różnych perspektyw, wyzwalając tym samym kolejne innowacje.”

„Jeśli miałbym wskazać naszą największą wartość, to jest nią właśnie multidyscyplinarność. Zajmujemy się bardzo wieloma, często odległymi od siebie dziedzinami. To jest nasza unikalna cecha (w skali Europy, jak również świata). Pozwala to spojrzeć na realizowane działania z różnych perspektyw, wyzwalając tym samym kolejne innowacje.”

„Jeśli miałbym wskazać naszą największą wartość, to jest nią właśnie multidyscyplinarność. Zajmujemy się bardzo wieloma, często odległymi od siebie dziedzinami. To jest nasza unikalna cecha (w skali Europy, jak również świata). Pozwala to spojrzeć na realizowane działania z różnych perspektyw, wyzwalając tym samym kolejne innowacje.”

„Jeśli miałbym wskazać naszą największą wartość, to jest nią właśnie multidyscyplinarność. Zajmujemy się bardzo wieloma, często odległymi od siebie dziedzinami. To jest nasza unikalna cecha (w skali Europy, jak również świata). Pozwala to spojrzeć na realizowane działania z różnych perspektyw, wyzwalając tym samym kolejne innowacje.”

„Jeśli miałbym wskazać naszą największą wartość, to jest nią właśnie multidyscyplinarność. Zajmujemy się bardzo wieloma, często odległymi od siebie dziedzinami. To jest nasza unikalna cecha (w skali Europy, jak również świata). Pozwala to spojrzeć na realizowane działania z różnych perspektyw, wyzwalając tym samym kolejne innowacje.”

Według raportu Global Quantum Computing Market (2024–2029), rynek obliczeń kwantowych ma wzrosnąć z $1,46 mld w 2024 r. do $4,76 mld do 2029 r., osiągając tym samym CAGR na poziomie 26,6%. Kluczowym czynnikiem wzrostu jest potrzeba bezpieczeństwa danych (kryptografia kwantowa) oraz zastosowania w medycynie i farmacji. Jednocześnie, według rankingu TOP500, Polska od 2024 r. posiada co najmniej kilka superkomputerów na liście najpotężniejszych maszyn świata, z których dwa należą do PCSS. Pozycjonuje to krajowy sektor HPC jako kluczowego gracza w europejskim wyścigu technologicznym, zwłaszcza w kontekście inicjatywy EuroHPC. (źródło: Mordor Intelligence, TOP500, EuroHPC).

Według raportu Global Quantum Computing Market (2024–2029), rynek obliczeń kwantowych ma wzrosnąć z $1,46 mld w 2024 r. do $4,76 mld do 2029 r., osiągając tym samym CAGR na poziomie 26,6%. Kluczowym czynnikiem wzrostu jest potrzeba bezpieczeństwa danych (kryptografia kwantowa) oraz zastosowania w medycynie i farmacji. Jednocześnie, według rankingu TOP500, Polska od 2024 r. posiada co najmniej kilka superkomputerów na liście najpotężniejszych maszyn świata, z których dwa należą do PCSS. Pozycjonuje to krajowy sektor HPC jako kluczowego gracza w europejskim wyścigu technologicznym, zwłaszcza w kontekście inicjatywy EuroHPC. (źródło: Mordor Intelligence, TOP500, EuroHPC).

Według raportu Global Quantum Computing Market (2024–2029), rynek obliczeń kwantowych ma wzrosnąć z $1,46 mld w 2024 r. do $4,76 mld do 2029 r., osiągając tym samym CAGR na poziomie 26,6%. Kluczowym czynnikiem wzrostu jest potrzeba bezpieczeństwa danych (kryptografia kwantowa) oraz zastosowania w medycynie i farmacji. Jednocześnie, według rankingu TOP500, Polska od 2024 r. posiada co najmniej kilka superkomputerów na liście najpotężniejszych maszyn świata, z których dwa należą do PCSS. Pozycjonuje to krajowy sektor HPC jako kluczowego gracza w europejskim wyścigu technologicznym, zwłaszcza w kontekście inicjatywy EuroHPC. (źródło: Mordor Intelligence, TOP500, EuroHPC).

Według raportu Global Quantum Computing Market (2024–2029), rynek obliczeń kwantowych ma wzrosnąć z $1,46 mld w 2024 r. do $4,76 mld do 2029 r., osiągając tym samym CAGR na poziomie 26,6%. Kluczowym czynnikiem wzrostu jest potrzeba bezpieczeństwa danych (kryptografia kwantowa) oraz zastosowania w medycynie i farmacji. Jednocześnie, według rankingu TOP500, Polska od 2024 r. posiada co najmniej kilka superkomputerów na liście najpotężniejszych maszyn świata, z których dwa należą do PCSS. Pozycjonuje to krajowy sektor HPC jako kluczowego gracza w europejskim wyścigu technologicznym, zwłaszcza w kontekście inicjatywy EuroHPC. (źródło: Mordor Intelligence, TOP500, EuroHPC).

Według raportu Global Quantum Computing Market (2024–2029), rynek obliczeń kwantowych ma wzrosnąć z $1,46 mld w 2024 r. do $4,76 mld do 2029 r., osiągając tym samym CAGR na poziomie 26,6%. Kluczowym czynnikiem wzrostu jest potrzeba bezpieczeństwa danych (kryptografia kwantowa) oraz zastosowania w medycynie i farmacji. Jednocześnie, według rankingu TOP500, Polska od 2024 r. posiada co najmniej kilka superkomputerów na liście najpotężniejszych maszyn świata, z których dwa należą do PCSS. Pozycjonuje to krajowy sektor HPC jako kluczowego gracza w europejskim wyścigu technologicznym, zwłaszcza w kontekście inicjatywy EuroHPC. (źródło: Mordor Intelligence, TOP500, EuroHPC).

PARTNER WYWIADU Z PCSS

R&D jako fundament przyszłości centrów danych

– od efektywności energetycznej po odporność na AI.

Dlaczego branża Data Center musi współpracować z nauką?

Nowoczesne Data Center to centra technologii

Vertiv jest globalnym liderem, dostarczającym infrastrukturę krytyczną dla centrów danych. Od początku istnienia firmy nasze działy R&D projektowały i rozwijały technologie dedykowane dla rynku Data Center. Te zasady nie uległy zmianie, gdyż wszystkie nasze rozwiązania mają przynosić korzyści naszym klientom. Zespoły naszych inżynierów R&D, projektując systemy, biorą pod uwagę aspekty techniczne, biznesowe, ale także środowiskowe i legislacyjne, aby to, co zaproponujemy klientom, zwiększało wydajność, bezpieczeństwo oraz przynosiło korzyści finansowe.

Obecny rynek centrów danych rozwija się bardzo dynamicznie dzięki rewolucji w dziedzinie sztucznej inteligencji. Skala i tempo tego wzrostu stanowią największe wyzwania, ponieważ postęp technologiczny wymaga znacznie szybszego opracowywania nowych produktów, a wzajemne zależności między różnymi technologiami zmuszają dostawców rozwiązań, takich jak Vertiv, do przyjęcia podejścia systemowego i projektowania komponentów infrastruktury, które płynnie współpracują ze sobą pod względem elektrycznym, mechanicznym, strukturalnym i cyfrowym.

Współpraca z pionierami popularyzuje innowacje

Instytucje badawcze, takie jak Poznańskie Centrum Superkomputerowo-Sieciowe (PCSS), zazwyczaj mają dostęp do nowoczesnych technologii znacznie wcześniej niż instytucje komercyjne. Wpływa na to m.in. współpraca z producentami rozwijającymi nowe technologie, kiedy to można przetestować nowe funkcjonalności w środowiskach dysponujących doświadczonymi zasobami, otwartymi umysłami oraz nieszablonowym podejściem do nowych rozwiązań.

Mogę przytoczyć kilka przykładów z mojego doświadczenia.

Technologia AI, która w tej chwili opanowuje centra danych, wywodzi się z technologii High Performance Computing, GPU intensive. O ile dobrze pamiętam, systemy z akceleratorami GPU były instalowane (oczywiście w dużo mniejszej skali) w PCSS, lata temu.

Podobnie z technologią chłodzenia cieczą (Liquid Cooling). Aby poprawnie schłodzić rozwiązania wysokiej gęstości, takie jak AI, chłodzenie cieczą staje się koniecznością i wkracza do serwerowni komercyjnych. Dla instytucji takich jak PCSS, nie jest to nowość, albowiem pierwsze instalacje tego typu były implementowane w Poznaniu już kilkanaście lat temu.

To tylko dwa przykłady, jednak mogę zaryzykować stwierdzenie, że technologia przetestowana i zaakceptowana przez ośrodki badawcze często staje się standardem dla branży IT oraz Data Center.

Testowanie technologii przyszłości dostępne dla rynku komercyjnego

Komercyjne centra danych testują nowoczesne technologie na kilka sposobów. Bardzo często dostawcy rozwiązań, tacy jak Vertiv, wspierają klientów, np. poprzez wspólne opracowywanie portfolio nowych systemów dostosowanych do ich konkretnych potrzeb. Przeprowadzamy również różnego rodzaju testy, w tym podczas procesu produkcji (np. Factory Whitness oraz Acceptance Tests), aby zapewnić klientów, że otrzymają zamówioną funkcjonalność i wydajność.

W Vertiv mamy 12 centrów obsługi klienta (Customer Experience Centers) w regionie EMEA i 27 na całym świecie, które zapewniają możliwości testowania nowych produktów. Zapewniamy również naszym klientom wsparcie w postaci projektów „Proof of Concept” lub „Demo Lab”, w ramach których wspólnie pracujemy nad potwierdzeniem określonych założeń (np. zwiększeniem efektywności energetycznej lub obniżeniem kosztów użytkowania).

.

PARTNER WYWIADU Z PCSS

R&D jako fundament przyszłości centrów danych

– od efektywności energetycznej po odporność na AI.

Dlaczego branża Data Center musi współpracować z nauką?

Nowoczesne Data Center to centra technologii

Vertiv jest globalnym liderem, dostarczającym infrastrukturę krytyczną dla centrów danych. Od początku istnienia firmy nasze działy R&D projektowały i rozwijały technologie dedykowane dla rynku Data Center. Te zasady nie uległy zmianie, gdyż wszystkie nasze rozwiązania mają przynosić korzyści naszym klientom. Zespoły naszych inżynierów R&D, projektując systemy, biorą pod uwagę aspekty techniczne, biznesowe, ale także środowiskowe i legislacyjne, aby to, co zaproponujemy klientom, zwiększało wydajność, bezpieczeństwo oraz przynosiło korzyści finansowe.

Obecny rynek centrów danych rozwija się bardzo dynamicznie dzięki rewolucji w dziedzinie sztucznej inteligencji. Skala i tempo tego wzrostu stanowią największe wyzwania, ponieważ postęp technologiczny wymaga znacznie szybszego opracowywania nowych produktów, a wzajemne zależności między różnymi technologiami zmuszają dostawców rozwiązań, takich jak Vertiv, do przyjęcia podejścia systemowego i projektowania komponentów infrastruktury, które płynnie współpracują ze sobą pod względem elektrycznym, mechanicznym, strukturalnym i cyfrowym.

Współpraca z pionierami popularyzuje innowacje

Instytucje badawcze, takie jak Poznańskie Centrum Superkomputerowo-Sieciowe (PCSS), zazwyczaj mają dostęp do nowoczesnych technologii znacznie wcześniej niż instytucje komercyjne. Wpływa na to m.in. współpraca z producentami rozwijającymi nowe technologie, kiedy to można przetestować nowe funkcjonalności w środowiskach dysponujących doświadczonymi zasobami, otwartymi umysłami oraz nieszablonowym podejściem do nowych rozwiązań.

Mogę przytoczyć kilka przykładów z mojego doświadczenia.

Technologia AI, która w tej chwili opanowuje centra danych, wywodzi się z technologii High Performance Computing, GPU intensive. O ile dobrze pamiętam, systemy z akceleratorami GPU były instalowane (oczywiście w dużo mniejszej skali) w PCSS, lata temu.

Podobnie z technologią chłodzenia cieczą (Liquid Cooling). Aby poprawnie schłodzić rozwiązania wysokiej gęstości, takie jak AI, chłodzenie cieczą staje się koniecznością i wkracza do serwerowni komercyjnych. Dla instytucji takich jak PCSS, nie jest to nowość, albowiem pierwsze instalacje tego typu były implementowane w Poznaniu już kilkanaście lat temu.

To tylko dwa przykłady, jednak mogę zaryzykować stwierdzenie, że technologia przetestowana i zaakceptowana przez ośrodki badawcze często staje się standardem dla branży IT oraz Data Center.

Testowanie technologii przyszłości dostępne dla rynku komercyjnego

Komercyjne centra danych testują nowoczesne technologie na kilka sposobów. Bardzo często dostawcy rozwiązań, tacy jak Vertiv, wspierają klientów, np. poprzez wspólne opracowywanie portfolio nowych systemów dostosowanych do ich konkretnych potrzeb. Przeprowadzamy również różnego rodzaju testy, w tym podczas procesu produkcji (np. Factory Whitness oraz Acceptance Tests), aby zapewnić klientów, że otrzymają zamówioną funkcjonalność i wydajność.

W Vertiv mamy 12 centrów obsługi klienta (Customer Experience Centers) w regionie EMEA i 27 na całym świecie, które zapewniają możliwości testowania nowych produktów. Zapewniamy również naszym klientom wsparcie w postaci projektów „Proof of Concept” lub „Demo Lab”, w ramach których wspólnie pracujemy nad potwierdzeniem określonych założeń (np. zwiększeniem efektywności energetycznej lub obniżeniem kosztów użytkowania).

.

PARTNER WYWIADU Z PCSS

R&D jako fundament przyszłości centrów danych

– od efektywności energetycznej po odporność na AI.

Dlaczego branża Data Center musi współpracować z nauką?

Nowoczesne Data Center to centra technologii

Vertiv jest globalnym liderem, dostarczającym infrastrukturę krytyczną dla centrów danych. Od początku istnienia firmy nasze działy R&D projektowały i rozwijały technologie dedykowane dla rynku Data Center. Te zasady nie uległy zmianie, gdyż wszystkie nasze rozwiązania mają przynosić korzyści naszym klientom. Zespoły naszych inżynierów R&D, projektując systemy, biorą pod uwagę aspekty techniczne, biznesowe, ale także środowiskowe i legislacyjne, aby to, co zaproponujemy klientom, zwiększało wydajność, bezpieczeństwo oraz przynosiło korzyści finansowe.

Obecny rynek centrów danych rozwija się bardzo dynamicznie dzięki rewolucji w dziedzinie sztucznej inteligencji. Skala i tempo tego wzrostu stanowią największe wyzwania, ponieważ postęp technologiczny wymaga znacznie szybszego opracowywania nowych produktów, a wzajemne zależności między różnymi technologiami zmuszają dostawców rozwiązań, takich jak Vertiv, do przyjęcia podejścia systemowego i projektowania komponentów infrastruktury, które płynnie współpracują ze sobą pod względem elektrycznym, mechanicznym, strukturalnym i cyfrowym.

Współpraca z pionierami popularyzuje innowacje

Instytucje badawcze, takie jak Poznańskie Centrum Superkomputerowo-Sieciowe (PCSS), zazwyczaj mają dostęp do nowoczesnych technologii znacznie wcześniej niż instytucje komercyjne. Wpływa na to m.in. współpraca z producentami rozwijającymi nowe technologie, kiedy to można przetestować nowe funkcjonalności w środowiskach dysponujących doświadczonymi zasobami, otwartymi umysłami oraz nieszablonowym podejściem do nowych rozwiązań.

Mogę przytoczyć kilka przykładów z mojego doświadczenia.

Technologia AI, która w tej chwili opanowuje centra danych, wywodzi się z technologii High Performance Computing, GPU intensive. O ile dobrze pamiętam, systemy z akceleratorami GPU były instalowane (oczywiście w dużo mniejszej skali) w PCSS, lata temu.

Podobnie z technologią chłodzenia cieczą (Liquid Cooling). Aby poprawnie schłodzić rozwiązania wysokiej gęstości, takie jak AI, chłodzenie cieczą staje się koniecznością i wkracza do serwerowni komercyjnych. Dla instytucji takich jak PCSS, nie jest to nowość, albowiem pierwsze instalacje tego typu były implementowane w Poznaniu już kilkanaście lat temu.

To tylko dwa przykłady, jednak mogę zaryzykować stwierdzenie, że technologia przetestowana i zaakceptowana przez ośrodki badawcze często staje się standardem dla branży IT oraz Data Center.

Testowanie technologii przyszłości dostępne dla rynku komercyjnego

Komercyjne centra danych testują nowoczesne technologie na kilka sposobów. Bardzo często dostawcy rozwiązań, tacy jak Vertiv, wspierają klientów, np. poprzez wspólne opracowywanie portfolio nowych systemów dostosowanych do ich konkretnych potrzeb. Przeprowadzamy również różnego rodzaju testy, w tym podczas procesu produkcji (np. Factory Whitness oraz Acceptance Tests), aby zapewnić klientów, że otrzymają zamówioną funkcjonalność i wydajność.

W Vertiv mamy 12 centrów obsługi klienta (Customer Experience Centers) w regionie EMEA i 27 na całym świecie, które zapewniają możliwości testowania nowych produktów. Zapewniamy również naszym klientom wsparcie w postaci projektów „Proof of Concept” lub „Demo Lab”, w ramach których wspólnie pracujemy nad potwierdzeniem określonych założeń (np. zwiększeniem efektywności energetycznej lub obniżeniem kosztów użytkowania).

.

PARTNER WYWIADU Z PCSS

R&D jako fundament przyszłości centrów danych

– od efektywności energetycznej po odporność na AI.

Dlaczego branża Data Center musi współpracować z nauką?

Nowoczesne Data Center to centra technologii

Vertiv jest globalnym liderem, dostarczającym infrastrukturę krytyczną dla centrów danych. Od początku istnienia firmy nasze działy R&D projektowały i rozwijały technologie dedykowane dla rynku Data Center. Te zasady nie uległy zmianie, gdyż wszystkie nasze rozwiązania mają przynosić korzyści naszym klientom. Zespoły naszych inżynierów R&D, projektując systemy, biorą pod uwagę aspekty techniczne, biznesowe, ale także środowiskowe i legislacyjne, aby to, co zaproponujemy klientom, zwiększało wydajność, bezpieczeństwo oraz przynosiło korzyści finansowe.

Obecny rynek centrów danych rozwija się bardzo dynamicznie dzięki rewolucji w dziedzinie sztucznej inteligencji. Skala i tempo tego wzrostu stanowią największe wyzwania, ponieważ postęp technologiczny wymaga znacznie szybszego opracowywania nowych produktów, a wzajemne zależności między różnymi technologiami zmuszają dostawców rozwiązań, takich jak Vertiv, do przyjęcia podejścia systemowego i projektowania komponentów infrastruktury, które płynnie współpracują ze sobą pod względem elektrycznym, mechanicznym, strukturalnym i cyfrowym.

Współpraca z pionierami popularyzuje innowacje

Instytucje badawcze, takie jak Poznańskie Centrum Superkomputerowo-Sieciowe (PCSS), zazwyczaj mają dostęp do nowoczesnych technologii znacznie wcześniej niż instytucje komercyjne. Wpływa na to m.in. współpraca z producentami rozwijającymi nowe technologie, kiedy to można przetestować nowe funkcjonalności w środowiskach dysponujących doświadczonymi zasobami, otwartymi umysłami oraz nieszablonowym podejściem do nowych rozwiązań.

Mogę przytoczyć kilka przykładów z mojego doświadczenia.

Technologia AI, która w tej chwili opanowuje centra danych, wywodzi się z technologii High Performance Computing, GPU intensive. O ile dobrze pamiętam, systemy z akceleratorami GPU były instalowane (oczywiście w dużo mniejszej skali) w PCSS, lata temu.

Podobnie z technologią chłodzenia cieczą (Liquid Cooling). Aby poprawnie schłodzić rozwiązania wysokiej gęstości, takie jak AI, chłodzenie cieczą staje się koniecznością i wkracza do serwerowni komercyjnych. Dla instytucji takich jak PCSS, nie jest to nowość, albowiem pierwsze instalacje tego typu były implementowane w Poznaniu już kilkanaście lat temu.

To tylko dwa przykłady, jednak mogę zaryzykować stwierdzenie, że technologia przetestowana i zaakceptowana przez ośrodki badawcze często staje się standardem dla branży IT oraz Data Center.

Testowanie technologii przyszłości dostępne dla rynku komercyjnego

Komercyjne centra danych testują nowoczesne technologie na kilka sposobów. Bardzo często dostawcy rozwiązań, tacy jak Vertiv, wspierają klientów, np. poprzez wspólne opracowywanie portfolio nowych systemów dostosowanych do ich konkretnych potrzeb. Przeprowadzamy również różnego rodzaju testy, w tym podczas procesu produkcji (np. Factory Whitness oraz Acceptance Tests), aby zapewnić klientów, że otrzymają zamówioną funkcjonalność i wydajność.

W Vertiv mamy 12 centrów obsługi klienta (Customer Experience Centers) w regionie EMEA i 27 na całym świecie, które zapewniają możliwości testowania nowych produktów. Zapewniamy również naszym klientom wsparcie w postaci projektów „Proof of Concept” lub „Demo Lab”, w ramach których wspólnie pracujemy nad potwierdzeniem określonych założeń (np. zwiększeniem efektywności energetycznej lub obniżeniem kosztów użytkowania).

.

PARTNER WYWIADU Z PCSS

R&D jako fundament przyszłości centrów danych

– od efektywności energetycznej po odporność na AI.

Dlaczego branża Data Center musi współpracować z nauką?

Nowoczesne Data Center to centra technologii

Vertiv jest globalnym liderem, dostarczającym infrastrukturę krytyczną dla centrów danych. Od początku istnienia firmy nasze działy R&D projektowały i rozwijały technologie dedykowane dla rynku Data Center. Te zasady nie uległy zmianie, gdyż wszystkie nasze rozwiązania mają przynosić korzyści naszym klientom. Zespoły naszych inżynierów R&D, projektując systemy, biorą pod uwagę aspekty techniczne, biznesowe, ale także środowiskowe i legislacyjne, aby to, co zaproponujemy klientom, zwiększało wydajność, bezpieczeństwo oraz przynosiło korzyści finansowe.

Obecny rynek centrów danych rozwija się bardzo dynamicznie dzięki rewolucji w dziedzinie sztucznej inteligencji. Skala i tempo tego wzrostu stanowią największe wyzwania, ponieważ postęp technologiczny wymaga znacznie szybszego opracowywania nowych produktów, a wzajemne zależności między różnymi technologiami zmuszają dostawców rozwiązań, takich jak Vertiv, do przyjęcia podejścia systemowego i projektowania komponentów infrastruktury, które płynnie współpracują ze sobą pod względem elektrycznym, mechanicznym, strukturalnym i cyfrowym.

Współpraca z pionierami popularyzuje innowacje

Instytucje badawcze, takie jak Poznańskie Centrum Superkomputerowo-Sieciowe (PCSS), zazwyczaj mają dostęp do nowoczesnych technologii znacznie wcześniej niż instytucje komercyjne. Wpływa na to m.in. współpraca z producentami rozwijającymi nowe technologie, kiedy to można przetestować nowe funkcjonalności w środowiskach dysponujących doświadczonymi zasobami, otwartymi umysłami oraz nieszablonowym podejściem do nowych rozwiązań.

Mogę przytoczyć kilka przykładów z mojego doświadczenia.

Technologia AI, która w tej chwili opanowuje centra danych, wywodzi się z technologii High Performance Computing, GPU intensive. O ile dobrze pamiętam, systemy z akceleratorami GPU były instalowane (oczywiście w dużo mniejszej skali) w PCSS, lata temu.

Podobnie z technologią chłodzenia cieczą (Liquid Cooling). Aby poprawnie schłodzić rozwiązania wysokiej gęstości, takie jak AI, chłodzenie cieczą staje się koniecznością i wkracza do serwerowni komercyjnych. Dla instytucji takich jak PCSS, nie jest to nowość, albowiem pierwsze instalacje tego typu były implementowane w Poznaniu już kilkanaście lat temu.

To tylko dwa przykłady, jednak mogę zaryzykować stwierdzenie, że technologia przetestowana i zaakceptowana przez ośrodki badawcze często staje się standardem dla branży IT oraz Data Center.

Testowanie technologii przyszłości dostępne dla rynku komercyjnego

Komercyjne centra danych testują nowoczesne technologie na kilka sposobów. Bardzo często dostawcy rozwiązań, tacy jak Vertiv, wspierają klientów, np. poprzez wspólne opracowywanie portfolio nowych systemów dostosowanych do ich konkretnych potrzeb. Przeprowadzamy również różnego rodzaju testy, w tym podczas procesu produkcji (np. Factory Whitness oraz Acceptance Tests), aby zapewnić klientów, że otrzymają zamówioną funkcjonalność i wydajność.

W Vertiv mamy 12 centrów obsługi klienta (Customer Experience Centers) w regionie EMEA i 27 na całym świecie, które zapewniają możliwości testowania nowych produktów. Zapewniamy również naszym klientom wsparcie w postaci projektów „Proof of Concept” lub „Demo Lab”, w ramach których wspólnie pracujemy nad potwierdzeniem określonych założeń (np. zwiększeniem efektywności energetycznej lub obniżeniem kosztów użytkowania).

.

PARTNER WYWIADU Z PCSS

R&D jako fundament przyszłości centrów danych

– od efektywności energetycznej po odporność na AI.

Dlaczego branża Data Center musi współpracować z nauką?

Nowoczesne Data Center to centra technologii

Vertiv jest globalnym liderem, dostarczającym infrastrukturę krytyczną dla centrów danych. Od początku istnienia firmy nasze działy R&D projektowały i rozwijały technologie dedykowane dla rynku Data Center. Te zasady nie uległy zmianie, gdyż wszystkie nasze rozwiązania mają przynosić korzyści naszym klientom. Zespoły naszych inżynierów R&D, projektując systemy, biorą pod uwagę aspekty techniczne, biznesowe, ale także środowiskowe i legislacyjne, aby to, co zaproponujemy klientom, zwiększało wydajność, bezpieczeństwo oraz przynosiło korzyści finansowe.

Obecny rynek centrów danych rozwija się bardzo dynamicznie dzięki rewolucji w dziedzinie sztucznej inteligencji. Skala i tempo tego wzrostu stanowią największe wyzwania, ponieważ postęp technologiczny wymaga znacznie szybszego opracowywania nowych produktów, a wzajemne zależności między różnymi technologiami zmuszają dostawców rozwiązań, takich jak Vertiv, do przyjęcia podejścia systemowego i projektowania komponentów infrastruktury, które płynnie współpracują ze sobą pod względem elektrycznym, mechanicznym, strukturalnym i cyfrowym.

Współpraca z pionierami popularyzuje innowacje

Instytucje badawcze, takie jak Poznańskie Centrum Superkomputerowo-Sieciowe (PCSS), zazwyczaj mają dostęp do nowoczesnych technologii znacznie wcześniej niż instytucje komercyjne. Wpływa na to m.in. współpraca z producentami rozwijającymi nowe technologie, kiedy to można przetestować nowe funkcjonalności w środowiskach dysponujących doświadczonymi zasobami, otwartymi umysłami oraz nieszablonowym podejściem do nowych rozwiązań.

Mogę przytoczyć kilka przykładów z mojego doświadczenia.

Technologia AI, która w tej chwili opanowuje centra danych, wywodzi się z technologii High Performance Computing, GPU intensive. O ile dobrze pamiętam, systemy z akceleratorami GPU były instalowane (oczywiście w dużo mniejszej skali) w PCSS, lata temu.

Podobnie z technologią chłodzenia cieczą (Liquid Cooling). Aby poprawnie schłodzić rozwiązania wysokiej gęstości, takie jak AI, chłodzenie cieczą staje się koniecznością i wkracza do serwerowni komercyjnych. Dla instytucji takich jak PCSS, nie jest to nowość, albowiem pierwsze instalacje tego typu były implementowane w Poznaniu już kilkanaście lat temu.

To tylko dwa przykłady, jednak mogę zaryzykować stwierdzenie, że technologia przetestowana i zaakceptowana przez ośrodki badawcze często staje się standardem dla branży IT oraz Data Center.

Testowanie technologii przyszłości dostępne dla rynku komercyjnego

Komercyjne centra danych testują nowoczesne technologie na kilka sposobów. Bardzo często dostawcy rozwiązań, tacy jak Vertiv, wspierają klientów, np. poprzez wspólne opracowywanie portfolio nowych systemów dostosowanych do ich konkretnych potrzeb. Przeprowadzamy również różnego rodzaju testy, w tym podczas procesu produkcji (np. Factory Whitness oraz Acceptance Tests), aby zapewnić klientów, że otrzymają zamówioną funkcjonalność i wydajność.

W Vertiv mamy 12 centrów obsługi klienta (Customer Experience Centers) w regionie EMEA i 27 na całym świecie, które zapewniają możliwości testowania nowych produktów. Zapewniamy również naszym klientom wsparcie w postaci projektów „Proof of Concept” lub „Demo Lab”, w ramach których wspólnie pracujemy nad potwierdzeniem określonych założeń (np. zwiększeniem efektywności energetycznej lub obniżeniem kosztów użytkowania).

.

Superkomputer, sieć PIONIER, Fabryka AI oraz najpotężniejszy w Europie komputer kwantowy – ta lista osiągnięć PCSS mogłaby sugerować, że mówimy o jednostce czysto hardware’owej, ale to byłoby błędem. Z rozmowy z liderami PCSS wyłania się obraz instytucji, która sprzedaje nie gigahertze i terabajty, lecz unikalne know-how – scenariusze i zdolność do łączenia pozornie odległych światów. To właśnie dzięki tej synergii polskie dziedzictwo kulturowe jest tak dobrze widoczne w Europie, a lekarze mają dostęp do AI w celu diagnozowania chorób.

Zastanawiamy się, czy ten model – polegający na proaktywnym wypełnianiu rynkowych nisz, zamiast biernym wynajmie infrastruktury – nie jest przyszłością dla całej branży data center? Podczas gdy komercyjni operatorzy borykają się z pozyskaniem klientów na AI, PCSS buduje ekosystem, który ma stymulować popyt. Czy polski sektor nieruchomości i FM jest gotowy, by przekształcić swoje wyzwania (zarządzanie energią, optymalizacja workplace) w projekty B+R realizowane we współpracy z takimi ośrodkami? Wszak innowacja jest dziś zasobem równie ważnym, jak prąd i chłodzenie.

.jpg)

.avif)